Con los chatbots de IA ahora que nos impulsan en prácticamente todas las aplicaciones y experiencia en línea, se está volviendo más común que las personas conversen con estas herramientas e incluso sientan un nivel de amistad con sus compañeros de IA favoritos a lo largo del tiempo.

Pero esa es una propuesta arriesgada. ¿Qué sucede cuando las personas comienzan a confiar en los chatbots de IA para compañía, incluso las relaciones, y luego esas herramientas de chatbot están desactivadas o pierden conexión de otras maneras?

¿Cuáles son los impactos sociales de las interacciones virtuales y cómo afectará eso a nuestro proceso comunal más amplio?

Estas son preguntas clave que, en gran parte, aparentemente se pasan por alto en nombre del progreso.

Pero recientemente, el Stanford Laboratorio de democracia deliberativa ha realizado una variedad de encuestas, junto con Meta, para tener una idea de cómo se sienten las personas sobre el impacto de la interacción de IA y qué límites deben implementarse en la participación de la IA (si corresponde).

Según Stanford:

“Por ejemplo, ¿cómo deberían ser los chatbots de IA humanos? ¿Cuáles son las preferencias de los usuarios al interactuar con los chatbots de IA? Y, ¿qué rasgos humanos deberían estar fuera de los límites para los chatbots de IA? Además, para algunos usuarios, parte de la apelación de los chatbots de IA radica en su imprevisibilidad o a veces las respuestas riesgosas. ¿Pero es demasiado?

Para tener una mejor idea de la respuesta general a estas preguntas, lo que también podría ayudar a guiar los planes de desarrollo de IA de Meta, el Laboratorio de Democracia encuestó recientemente a 1, 545 participantes de cuatro países (Brasil, Alemania, España y Estados Unidos) para obtener sus pensamientos sobre algunas de estas preocupaciones.

Puede consultar el informe completo aquí, pero en esta publicación, echaremos un vistazo a algunas de las notas clave.

En primer lugar, el estudio muestra que, en general, la mayoría de las personas ven beneficios de eficiencia potenciales en el uso de IA, pero menos en compañía.

Esta es una visión general interesante del pulso general de la respuesta de AI, en una gama de elementos clave.

Luego, el estudio hizo preguntas más específicas sobre los compañeros de IA, y qué límites se deben imponer en su uso.

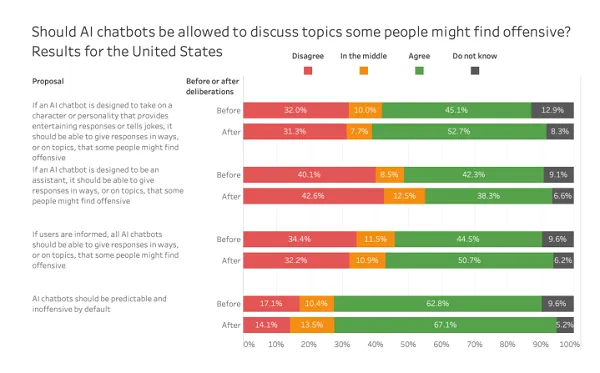

En esta consulta, la mayoría de los participantes indicaron que están de acuerdo con los chatbots que abordan temas potencialmente ofensivos, aunque alrededor del 40% estaban en contra (o en el medio).

Lo cual es interesante teniendo en cuenta la discusión más amplia de la libertad de expresión en los medios modernos. Parece que, dado el enfoque en ello, que la mayoría de las personas verían esto como una preocupación mayor, pero la división aquí indica que no hay un verdadero consenso sobre qué chatbots debería poder abordar.

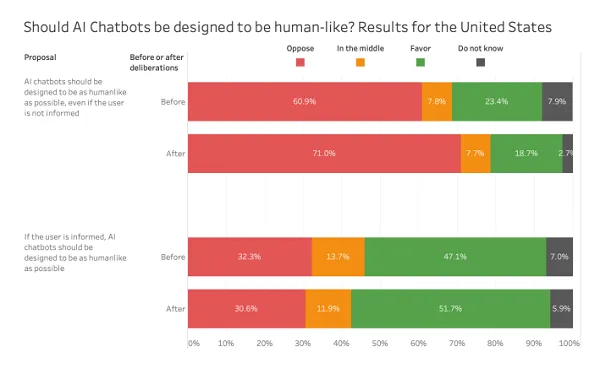

También se les preguntó a los participantes si piensan que los chatbots de IA deberían estar diseñados para replicar a los humanos.

Por lo tanto, hay un nivel significativo de preocupación por los chatbots de IA que juegan un papel humano, especialmente si los usuarios no están informados de que se están involucrando con un bot de IA.

Lo cual es interesante en el contexto del plan de Meta para desatar un ejército de perfiles de bot de IA en sus aplicaciones, y hacer que se involucren en Facebook e IG como si fueran personas reales. Meta no ha proporcionado ninguna información específica sobre cómo funcionaría esto todavía, ni qué tipo de divulgaciones planea mostrar para los perfiles de AI Bot. Pero las respuestas aquí sugerirían que las personas quieren estar claramente informadas de las cosas, en lugar de tratar de transmitirlos como personas reales.

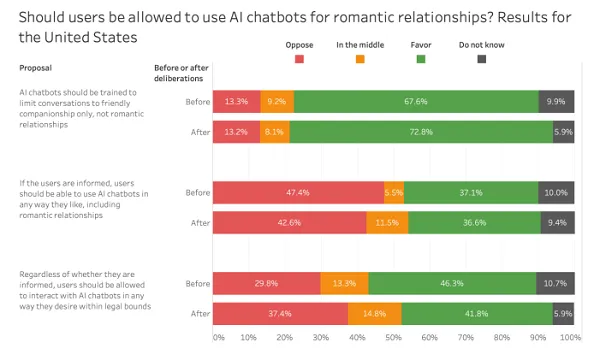

Además, las personas no parecen particularmente cómodas con la idea de los chatbots de IA como compañeros románticos:

Los resultados aquí muestran que la gran mayoría de las personas están a favor de las restricciones a las interacciones de IA, de modo que los usuarios (idealmente) no desarrollan relaciones románticas con bots, mientras que hay una división bastante uniforme de personas a favor y en contra de la idea de que las personas pueden interactuar con los chatbots de IA, sin embargo, quieren “dentro de los límites legales”.

Esta es un área particularmente arriesgada, como se señaló, dentro del cual simplemente no tenemos suficiente investigación sobre aún para hacer un llamado a los beneficios de salud mental o los impactos de ellos. Parece que esto podría ser un camino hacia el daño, pero tal vez, la participación romántica con una IA podría ser beneficiosa en muchos casos, para abordar la soledad y el aislamiento.

Pero es algo que necesita un estudio adecuado, y no debe permitirse ni promover por defecto.

Hay un montón más información en el informe completo, al que puede acceder aquí, planteando algunas preguntas clave sobre el desarrollo de la IA y nuestra creciente dependencia de los bots de IA.

Lo cual solo va a crecer, y como tal, necesitamos más investigación y información comunitaria de estos elementos para tomar decisiones más informadas sobre el desarrollo de la IA.