Meta dice que los cambios en su enfoque de moderación y aplicación, incluido el cambio a las notas comunitarias, están funcionando, con sus últimos informes de transparencia que muestran que Vio una reducción del 50% en los errores de aplicación en los Estados Unidos.

Este fue uno de los elementos de enfoque clave de su cambio, para garantizar que se permita más discurso y menos se restringe debido a las reglas de Meta. Las notas de la comunidad pueden ayudar a este respecto al permitir que Meta se vuelva a hacer cumplir su propia aplicación, a favor de permitir que la comunidad decida qué debería y no debe permitirse.

Y eso parece estar teniendo algún efecto, aunque la otra cara de eso podría ser que se permite que la más información errónea, en particular, prolifere en las aplicaciones de Meta, ya que una reducción en los errores también podría reflejar una reducción en la aplicación en general.

Esta es una de varias notas de la última ronda de datos de rendimiento de moderación de Meta, que también incluye información sobre el contenido eliminado por violaciones de reglas, solicitudes de información del gobierno, contenido ampliamente visto y más.

Puede ver todas las últimas ideas de Meta aquí, pero en esta publicación, echaremos un vistazo a algunas de las notas clave.

Mirando las notas de la comunidad específicamente, Meta dice que ahora es Se agregó la capacidad de escribir notas en los carretes, así como en las respuestas en los subprocesos, mientras que también se agrega la opción de solicitar una nota de la comunidad, ya que continúa expandiendo su proceso.

Y el enfoque de Notas de la comunidad claramente tiene mérito, para permitir que los usuarios tengan información sobre lo que está permitido, y no, en cada aplicación. Pero nuevamente, también vale la pena señalar que cualquier beneficio de las notas de la comunidad también podría ser contrarrestada por una expansión relativa en problemas no reportados que no se pueden rastrear.

Por ejemplo, la investigación ha demostrado que la aparición de una nota comunitaria en una publicación puede reducir significativamente la distribución de reclamos falsos realizados en esa actualización. Pero eso solo es relevante si se muestra una nota, y un defecto clave en el sistema de notas de la comunidad en X es que El 85% de todas las notas comunitarias nunca se muestran a los usuarios X.

La necesidad de un acuerdo de los usuarios de puntos de vista políticos opuestos significa que la mayoría de las notas nunca ven la luz del día, porque en muchos de los problemas políticos más divisivos, ese acuerdo nunca se llegará a ese acuerdo.

Entonces, si no se muestra una nota, no puede reducir el alcance de una publicación. Lo mismo ocurre con las quejas sobre errores, las personas no pueden quejarse de un error si nunca se muestra una nota. Lo que podría significar que se permite proliferar mucha información errónea, a pesar de estos indicadores aparentemente positivos.

Entonces, básicamente, no sé si una reducción del 50% en los errores de aplicación es necesariamente el marcador positivo que Meta lo presenta.

En términos de aplicación específica del caso, los datos de Meta muestran que ha habido un aumento en los casos de desnudez/contenido sexual en Facebook tardadamente:

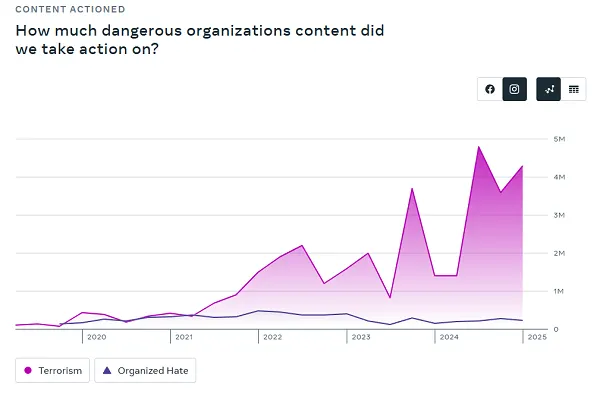

Si bien el contenido eliminado bajo su política de “organizaciones peligrosas” ha aumentado en IG (Meta dice que esto se debió a un error que se está abordando):

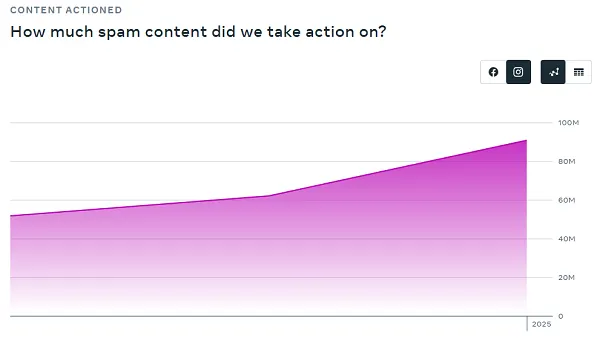

También se está eliminando más spam en Instagram:

Y sobre el contenido de suicidio, suicidio y trastorno alimentario también ha aumentado:

Algunas de estas tendencias se deben a Las mejoras realizadas en la tecnología de detección de Meta, que incorpora cada vez más modelos de idiomas grandes para refinar la detección:

“Las pruebas tempranas sugieren que los LLM pueden funcionar mejor que los modelos de aprendizaje automático existentes, o mejorar los existentes. Tras pruebas adicionales, estamos comenzando a ver que los LLM operan más allá del rendimiento humano para áreas de políticas seleccionadas “.

Mientras que otros podrían ser indicativos de preocupaciones más amplias en estas áreas.

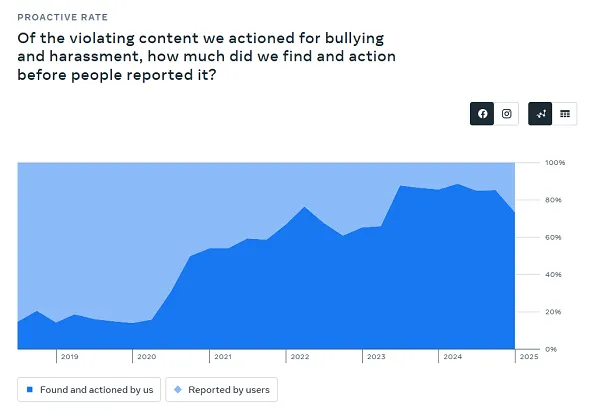

Sin embargo, de igual preocupación en lo que respecta a la implementación de su nuevo enfoque de moderación, la detección automatizada del acoso y el acoso disminuyó en un 12%.

¿Podría ser eso porque Meta permite que más de esto suceda al dejar que los usuarios decidan qué deberían y no deberían informarse?

Para ser justos, Meta también ha notado que algo de esto sería atribuible a que reduzca su detección automatizada en áreas de altos falsos positivos, para refinar y mejorar sus modelos. Por lo tanto, podría haber un par de razones para esto, pero sugiere que podría permitir más contenido de contenido para pasar como resultado.

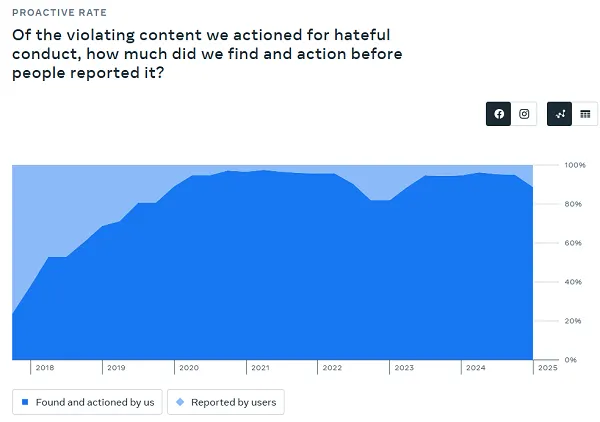

Meta también informó una reducción del 7% en la detección proactiva de la conducta de odio:

Por lo tanto, estos incidentes aún están sucediendo, es solo que la detección proactiva de Meta ahora es aparentemente menos sensible a tal, con Meta también optando por dejar que las notas de la comunidad recojan la holgura en tales informes.

¿Es eso una mejora? No lo sé, pero es otro marcador que apunta al impacto de este cambio en el enfoque, lo que podría estar llevando a más incidentes de daño en sus aplicaciones. AND, cuando también considera la escala masiva de las plataformas de Meta, una pequeña disminución porcentual aquí es en realidad miles o millones de incidentes más.

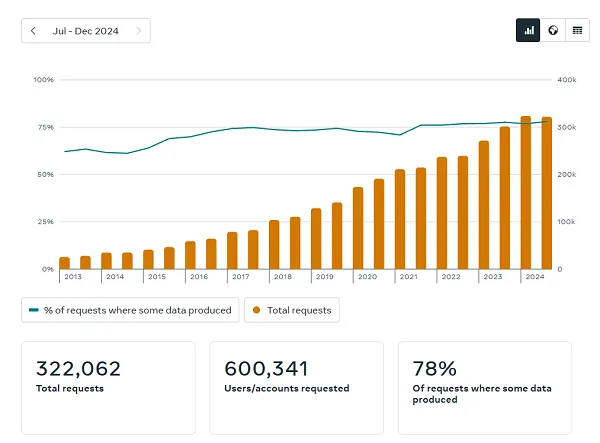

En términos de solicitudes de información del gobierno, los números de respuesta de Meta se mantuvieron relativamente estables en comparación con su último informe:

Meta dice que India fue el mejor solicitante a este respecto (un aumento de+3.8% en las solicitudes de este trimestre), seguido por los Estados Unidos, Brasil y Alemania.

Además, Meta dice que Las cuentas falsas representan aproximadamente el 3% de sus usuarios activos mensuales en todo el mundo en Facebook. Meta debe tener más confianza en sus procesos de detección de cuentas falsas, ya que generalmente se informa el estándar de la industria del 5% en esta medida. Pero ahora, parece creer que está atrapando más falsificaciones.

Las experiencias de los usuarios individuales variarán.

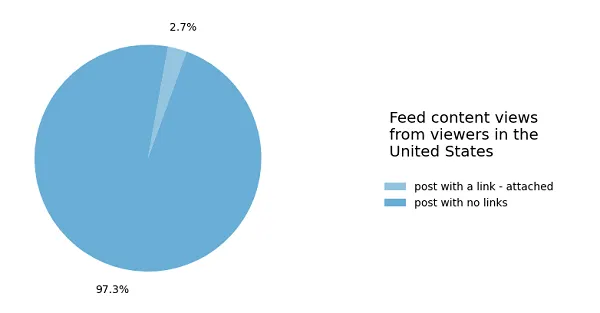

En términos de contenido ampliamente visto, este gráfico continúa pareciendo triste para los editores y aquellos que buscan conducir el tráfico desde Facebook.

Como se puede ver, El 97.3% de las opiniones de publicaciones en Facebook en los EE. UU. Durante el primer trimestre de 2025 no incluyeron un enlace a una fuente fuera de esa aplicación.

Aunque en realidad es una ligera mejora en el último informe de Meta (+0.6% en publicaciones de enlace). Pero si esperaba que el movimiento de Meta para permitir que más contenido de editor ganara más alcance en la aplicación una vez más, como resultado de que relaje sus reglas en torno a la discusión política, los números muestran que ese no es el caso.

Sin embargo, anecdóticamente, algunas publicaciones han informado un aumento en el tráfico de referencias de Facebook este año.

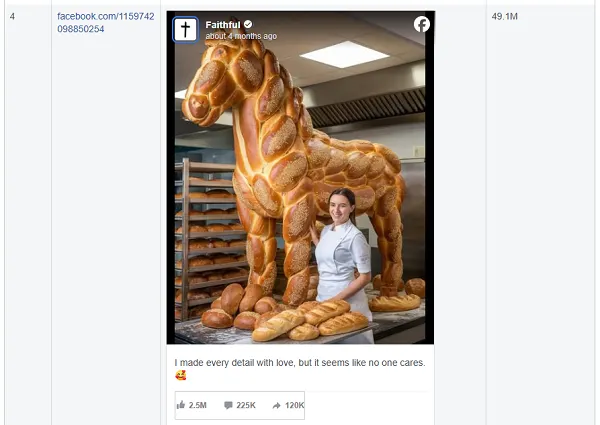

Ah, y si te preguntas qué está recibiendo tracción en Facebook, Ai Slop sigue funcionando ridículamente bien:

Eso y la mezcla habitual de actualizaciones de celebridades al estilo de la revista de supermercados y publicaciones virales.

Entonces, ¿Facebook está mejorando como resultado del cambio a las notas de la comunidad?

Bueno, depende de las métricas que estás usando. Algunos datos aquí sugieren que el enfoque de cambio en moderación está proporcionando beneficios, pero es la omisión de los datos que probablemente sea igual de relevante en esas estadísticas.

En general, sin embargo, ha habido algunos cambios preocupantes en las acciones tomadas en ciertos elementos, lo que podría sugerir que Meta permite un contenido más dañino para propagarse a través de sus aplicaciones.

Sin embargo, no sabemos porque estas cifras solo muestran resultados, no se pierden oportunidades, y sin el contexto completo, es imposible decir si su cambio está teniendo un impacto positivo general.

Puede consultar todos los últimos informes de transparencia de Meta aquí.