Este audio se genera automáticamente. Por favor, háganos saber si tiene algún comentario.

Dadas las últimas revelaciones sobre Grok de xAI produciendo contenido ilícito en masa, a veces de menores, esto parece una descripción general oportuna.

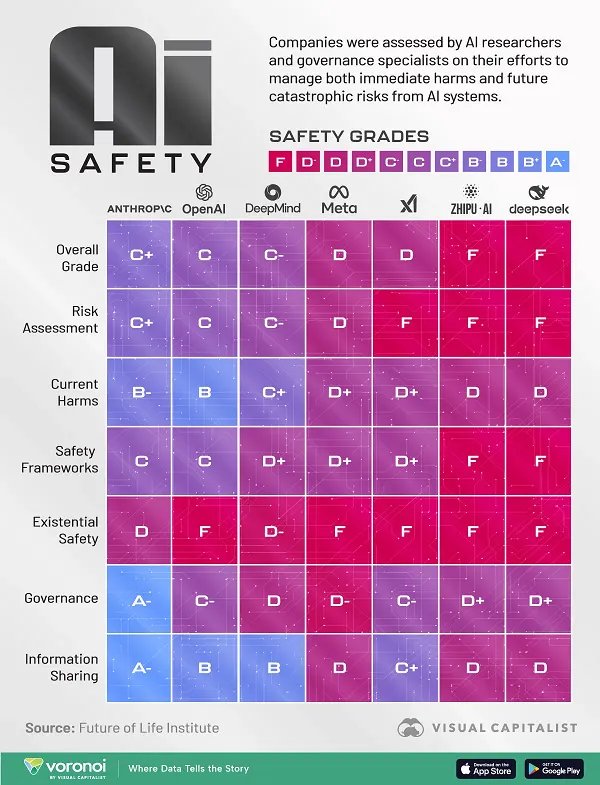

El equipo del Future of Life Institute llevó a cabo recientemente una revisión de seguridad de algunas de las herramientas de inteligencia artificial más populares del mercado, incluidas Meta AI, ChatGPT de OpenAI, Grok y más.

La revisión analizó seis elementos clave:

- Evaluación de riesgos: esfuerzos para garantizar que la herramienta no pueda manipularse ni utilizarse con fines perjudiciales.

- Daños actuales: incluidos riesgos de seguridad de datos y marcas de agua digitales

- Marcos de seguridad: el proceso que tiene cada plataforma para identificar y abordar el riesgo.

- Seguridad existencial: si el proyecto está siendo monitoreado para detectar evoluciones inesperadas en la programación.

- Gobernanza: el lobby de la empresa sobre la gobernanza de la IA y las normas de seguridad de la IA

- Intercambio de información: transparencia del sistema y conocimiento de cómo funciona

Con base en estos seis elementos, el informe le dio a cada proyecto de IA una puntuación de seguridad general, que refleja una evaluación más amplia de cómo cada uno gestiona el riesgo de desarrollo.

El equipo de Visual Capitalist ha traducido estos resultados en la siguiente infografía, que proporciona algunos elementos adicionales para reflexionar sobre el desarrollo de la IA y hacia dónde podríamos dirigirnos (especialmente ahora que la Casa Blanca busca eliminar posibles impedimentos para el desarrollo de la IA).