Google anunció que el modo AI ahora admite la búsqueda visual, permitiéndole usar imágenes y lenguaje natural juntos en la misma conversación.

La actualización se lanzará esta semana en inglés en los Estados Unidos.

Qué hay de nuevo

La búsqueda visual se conversa

La actualización de Google al modo AI tiene como objetivo abordar el desafío de buscar algo que sea difícil de describir.

Puede comenzar con texto o una imagen, luego refinar los resultados naturalmente con las preguntas de seguimiento.

Robby Stein, vicepresidente de gestión de productos para Google Search, y Lilian Rincon, vicepresidente de gestión de productos para Google Shopping, escribieron:

“Todos hemos estado allí: mirar una pantalla, buscar algo que no pueda expresar con palabras. Pero, ¿qué pasaría si pudieras mostrar o decirle a Google lo que estás pensando y obtener una rica gama de resultados visuales?”

Google proporciona un ejemplo que comienza con una búsqueda de “inspiración del dormitorio maximalista” y se refina con “más opciones con tonos oscuros y estampados audaces”.

Crédito de la imagen: Google

Crédito de la imagen: GoogleCada imagen se vincula a su fuente, por lo que los buscadores pueden hacer clic cuando encuentren lo que quieren.

Comprar sin filtros

En lugar de utilizar filtros convencionales para el estilo, el tamaño, el color y la marca, puede describir los productos con conversación.

Por ejemplo, preguntar “jeans de barril que no sean demasiado holgados” encontrarán productos adecuados, y puede reducir aún más las opciones con solicitudes como “Muéstrame la longitud del tobillo”.

Crédito de la imagen: Google

Crédito de la imagen: GoogleEsta experiencia funciona con el gráfico de compras, que abarca más de 50 mil millones de listados de productos de los principales minoristas y tiendas locales.

La compañía dice que más de 2 mil millones de listados se actualizan cada hora para mantener detalles, como revisiones, ofertas, colores disponibles y estado de stock actualizado.

Fundación técnica

Construyendo la búsqueda de lentes y imágenes, las habilidades visuales ahora incluyen la comprensión multimodal y de lenguaje avanzada de Gemini 2.5.

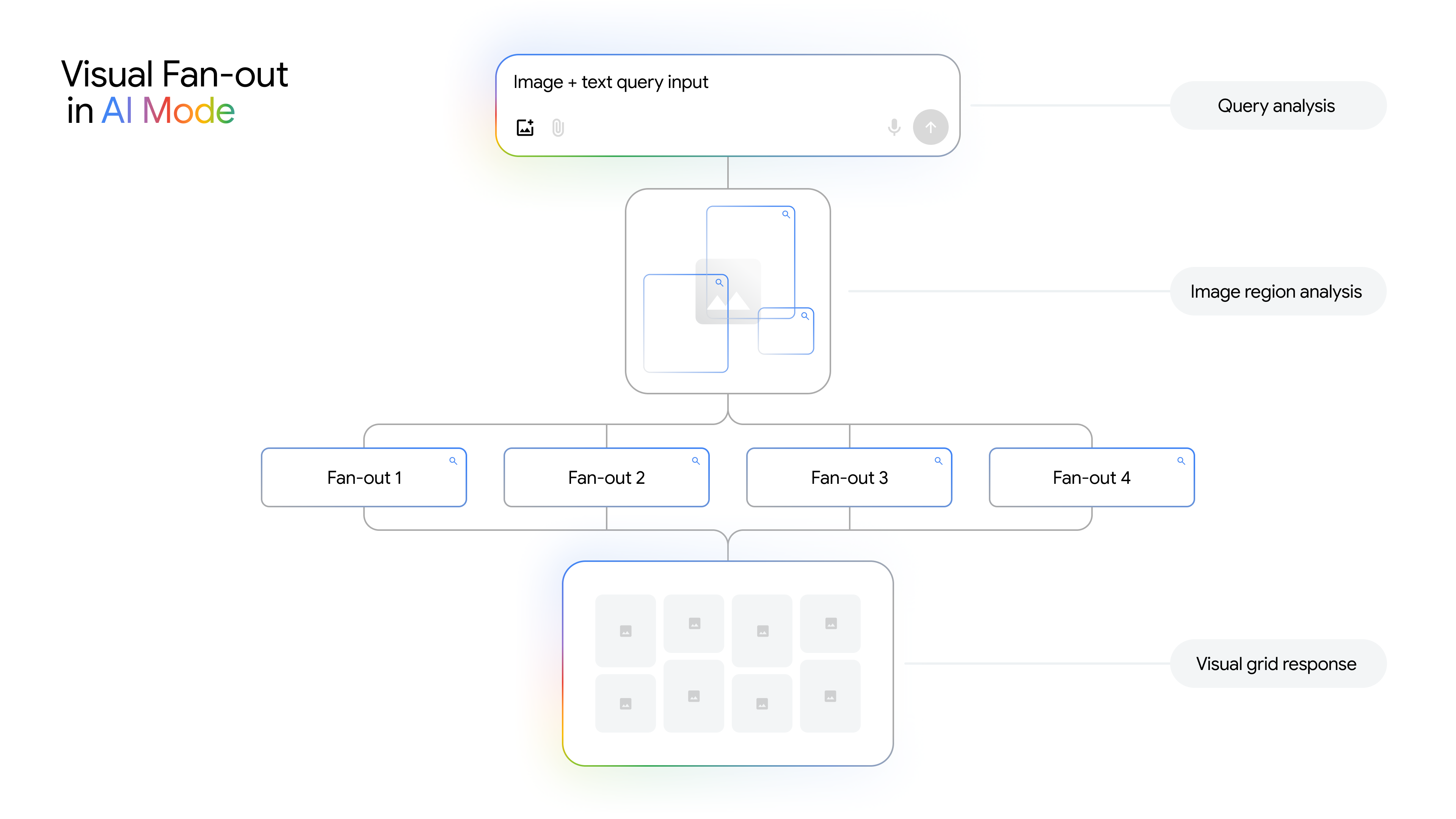

Google presenta una técnica llamada “Faneut de búsqueda visual”, donde ejecuta varias consultas relacionadas en el fondo para comprender mejor lo que hay en una imagen y los matices de su pregunta.

Además, en los dispositivos móviles, puede buscar dentro de una imagen específica y preguntar seguimientos de conversación sobre lo que ve.

Crédito de la imagen: Google

Crédito de la imagen: GoogleContexto adicional

En una mesa redonda de medios a la que asistió Search Engine Journal, un portavoz de Google dijo:

- Cuando una consulta incluye modificadores subjetivos, como “demasiado holgado”, el sistema puede usar señales de personalización para inferir lo que probablemente quiere decir y devolver los resultados que coinciden mejor con esa preferencia. El portavoz no detalló qué señales se usan o cómo se ponderan.

- Para las fuentes de imagen, los sistemas no diferencian explícitamente fotos reales de imágenes generadas por IA para esta función. Sin embargo, la clasificación puede favorecer los resultados de fuentes autorizadas y otras señales de calidad, lo que puede hacer que las fotos reales tengan más probabilidades de aparecer en algunos casos. No se compartió ninguna política o estándar de detección separado.

Por qué esto importa

Para los equipos de SEO y de comercio electrónico, las imágenes se están volviendo aún más esenciales. A medida que Google mejore para comprender las señales visuales detalladas, las fotos de productos de alta calidad y las imágenes de estilo de vida pueden aumentar su visibilidad.

Dado que Google actualiza el gráfico de compras cada hora, es importante mantener su producto alimentados precisos y actualizados.

A medida que la búsqueda continúa siendo más visual y conversacional, recuerde que muchas experiencias de compra pueden comenzar con una imagen simple o una descripción informal en lugar de palabras clave exactas.

Mirando hacia el futuro

La nueva experiencia se implementa esta semana en inglés en los EE. UU., Google no ha compartido el tiempo para otros idiomas o regiones.

(Tagstotranslate) Noticias