Como destaca el CEO de Meta Mark Zuckerberg en una visión general reciente del impacto de la IA, Meta depende cada vez más de los sistemas con AI para más aspectos de su desarrollo interno y gestión, incluida la codificación, la orientación de anuncios, la evaluación de riesgos y más.

Y eso pronto podría convertirse en un factor aún mayor, y Según los informes, Meta planea usar IA para hasta el 90% de todas sus evaluaciones de riesgos en Facebook e Instagram, incluidos todos los cambios en el desarrollo de productos y las reglas.

Según lo informado por NPR:

“Durante años, cuando Meta lanzó nuevas funciones para Instagram, WhatsApp y Facebook, los equipos de revisores evaluaron los posibles riesgos: ¿podría violar la privacidad de los usuarios? ¿Podría causar daño a los menores? ¿Podría empeorar la propagación del contenido engañoso o tóxico? Hasta hace poco, lo que se conoce dentro de Meta como revisiones de privacidad e integridad se realizó casi por completo por evaluadores humanos, pero ahora, según documentos internos de la compañía obtenidos por NPR, hasta el 90% de todas las evaluaciones de riesgos pronto se automatizarán “.

Lo que parece potencialmente problemático, lo que confía mucho en las máquinas para proteger a los usuarios de algunos de los peores aspectos de la interacción en línea.

Pero Meta confía en que sus sistemas de IA pueden manejar tales tareas, incluida la moderación, que mostró en su informe de transparencia para Q1, que publicó la semana pasada.

A principios de año, Meta anunció que cambiaría su enfoque a violaciones de políticas “menos severas”, con el fin de reducir la cantidad de errores y restricciones de aplicación.

Al cambiar ese enfoque, Meta dice que cuando encuentra que sus sistemas automatizados están cometiendo demasiados errores, ahora está desactivando esos sistemas por completo a medida que funciona para mejorarlos, mientras que también es:

“… deshacerse de la mayoría de las degradaciones (de contenido) y requerir una mayor confianza que el contenido viola para el resto. Y vamos a sintonizar nuestros sistemas para requerir un grado de confianza mucho más alto antes de que se elimine un contenido “.

Entonces, esencialmente, Meta’s Refining sus sistemas de detección automatizados para garantizar que no eliminen las publicaciones demasiado apresuradamente. Y Meta dice que, hasta ahora, esto ha sido un éxito, lo que resulta en una reducción del 50% en los errores de aplicación de reglas.

Lo cual es aparentemente positivo, pero, de nuevo, una reducción en los errores también puede significar que se está mostrando más contenido de violación a los usuarios en sus aplicaciones.

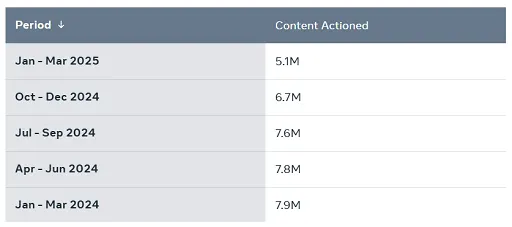

Que también se reflejó en sus datos de aplicación:

Como puede ver en este cuadro, la detección automatizada de Bullying and Haressment en Facebook de Meta Meta disminuyó en un 12% en Q1, lo que significa que más de ese contenido estaba pasando, debido al cambio de Meta en el enfoque.

Lo cual, en un gráfico como este, no parece un impacto significativo. Pero en números brutos, esa es una variación de millones de publicaciones de violación en las que Meta está tomando medidas más rápidas y millones de comentarios dañinos que se muestran a los usuarios en sus aplicaciones como resultado de este cambio.

El impacto, entonces, podría ser significativo, pero Meta busca más dependencia de los sistemas de IA para comprender y hacer cumplir estas reglas en el futuro, para maximizar sus esfuerzos en este frente.

¿Funcionará eso? Bueno, todavía no lo sabemos, y este es solo un aspecto de cómo Meta busca integrar la IA para evaluar y actuar sus diversas reglas y políticas, para proteger mejor a sus miles de millones de usuarios.

Como se señaló, Zuckerberg también ha marcado que “En algún momento de los próximos 12 a 18 meses”, la mayor parte de la base del código en evolución de Meta será escrita por AI.

Esa es una aplicación más lógica de los procesos de IA, ya que pueden replicar el código ingiriendo grandes cantidades de datos y luego proporcionando evaluaciones basadas en coincidencias lógicas.

Pero cuando habla de reglas y políticas, y cosas que podrían tener un gran impacto en cómo los usuarios experimentan cada aplicación, eso parece un uso más riesgoso de las herramientas de IA.

En respuesta a NPR, Meta dijo que Los cambios en la revisión del riesgo del producto seguirán supervisados por los humanos, y que solo se están automatizando las “decisiones de bajo riesgo”. Pero aun así, es una ventana a la posible expansión futura de la IA, donde los sistemas automatizados se basan cada vez más para dictar experiencias humanas reales.

¿Es esa una mejor manera de seguir en estos elementos?

Tal vez terminará siendo así, pero todavía parece un riesgo significativo, cuando estamos hablando de una escala tan grande de impactos potenciales, si cometen errores.