TL;DR

- Search Console tiene algunas limitaciones bastante severas en cuanto a almacenamiento, datos anonimizados e incompletos y límites de API.

- Puede evitar muchas de estas limitaciones y hacer que GSC trabaje mucho más para usted, pero configurando muchas más propiedades a nivel de subcarpeta.

- Puede tener hasta 1000 propiedades en su cuenta de Search Console. No se limite a una propiedad a nivel de dominio.

- Todo esto permite una indexación, consultas y análisis a nivel de página mucho más completos. Todo gratis. Especialmente si utiliza el límite de indexación de URL API de 2000 por propiedad.

Ahora bien, esto se aplica principalmente a sitios empresariales. Sitios con una estructura profunda de subcarpetas y un rico historial de publicación de una gran cantidad de contenido. Técnicamente, esto no es específico del editor. Si trabaja para una marca de comercio electrónico, esto también debería resultar increíblemente útil.

A mí y a él nos encantan todos los sitios grandes y torpes por igual.

¿Qué es una propiedad de Search Console?

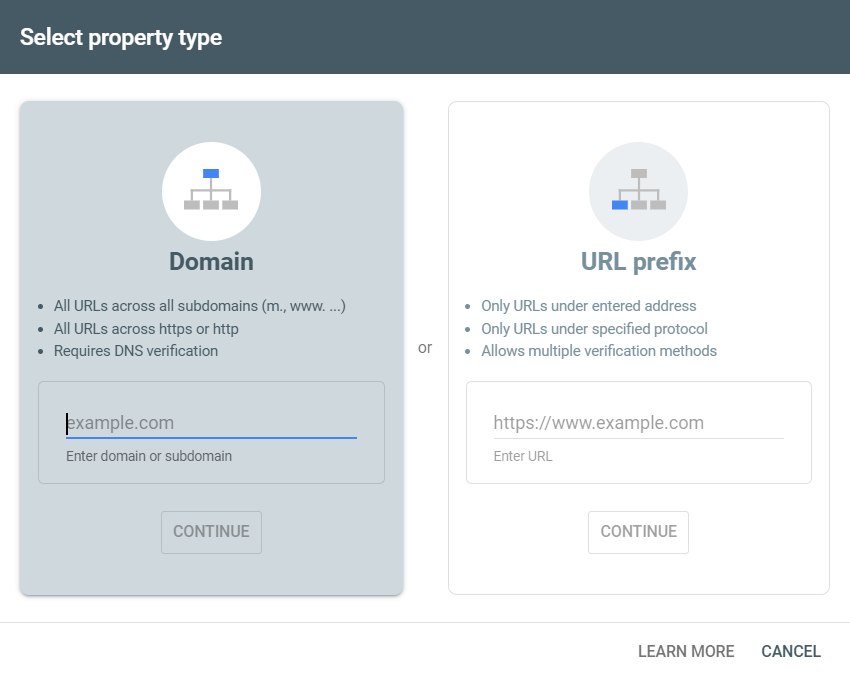

Una propiedad de Search Console es un dominio, subcarpeta o variación de subdominio de un sitio web que puede demostrar que es de su propiedad.

Puede configurar propiedades a nivel de dominio o a nivel de prefijo de URL (Crédito de la imagen: Harry Clarkson-Bennett)

Puede configurar propiedades a nivel de dominio o a nivel de prefijo de URL (Crédito de la imagen: Harry Clarkson-Bennett)Si acaba de configurar una propiedad a nivel de dominio, aún tendrá acceso a todas las cosas buenas que ofrece GSC. Datos de clics e impresiones, análisis de indexación y el informe de estadísticas de rastreo (solo disponible en propiedades a nivel de dominio), por nombrar algunos. Pero se ve obstaculizado por algunas limitaciones bastante graves:

- 1000 filas de consultas y datos a nivel de página.

- Límite de API de 2000 URL para análisis de nivel de indexación cada día.

- Datos de palabras clave muestreados (y enmascaramiento de privacidad).

- Datos faltantes (en algunos casos, 70% o más).

- 16 meses de datos.

Si bien el límite de 16 meses y los datos de palabras clave de muestra requieren que exportes tus datos a BigQuery (o utilices una de las herramientas siguientes), puedes mejorar enormemente tu experiencia con GSC haciendo un mejor uso de las propiedades.

Hay varios métodos de verificación disponibles: verificación de DNS, etiqueta HTML o carga de archivos, código de seguimiento de Google Analytics. Una vez que haya configurado y verificado una propiedad a nivel de dominio, podrá agregar cualquier propiedad a nivel secundario. Subdominios o subcarpetas por igual.

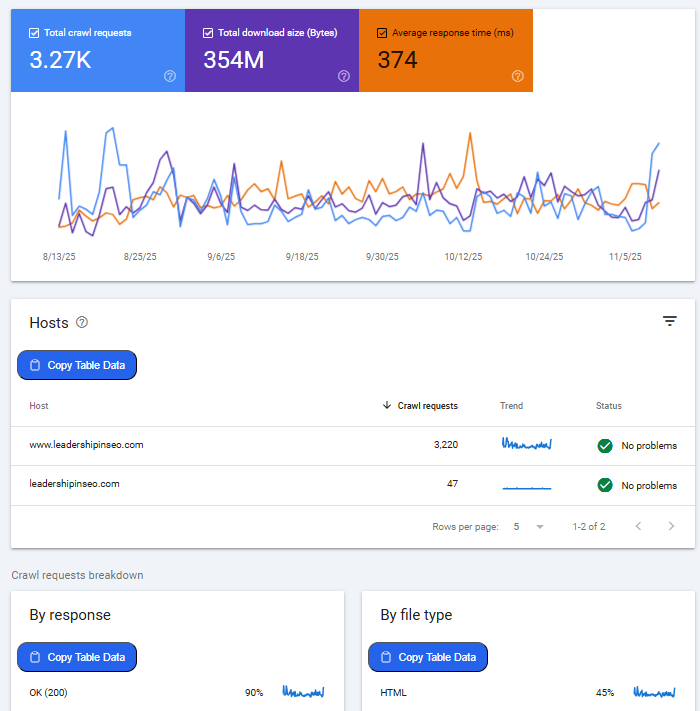

El informe de estadísticas de rastreo puede ser una mina de oro absoluta, especialmente para sitios grandes (¡no este!) (Crédito de la imagen: Harry Clarkson-Bennett)

El informe de estadísticas de rastreo puede ser una mina de oro absoluta, especialmente para sitios grandes (¡no este!) (Crédito de la imagen: Harry Clarkson-Bennett)El informe de estadísticas de rastreo puede ser extremadamente útil para depurar problemas como picos en las URL de parámetros o subdominios nocivos. Especialmente en sitios grandes donde los departamentos hacen cosas de las que usted y yo no nos enteramos hasta que es demasiado tarde.

Pero al desglosar los cambios a nivel de host, tipo de archivo y código de respuesta, puede detener las cosas en el origen. Identifique fácilmente los problemas que afectan su presupuesto de rastreo antes de querer golpear a alguien con su enfoque sobre enlaces internos y URL de parámetros.

Generalmente, al menos. A veces la gente sólo necesita un buen grupo. Metafóricamente hablando, por supuesto.

Los subdominios suelen verse como entidades separadas con su propio presupuesto de rastreo. Sin embargo, este no es siempre el caso. Según John Mueller, es posible que Google agrupe sus subdominios con fines de presupuesto de rastreo.

Según Gary Illyes, el presupuesto de rastreo normalmente se establece por nombre de host. Por lo tanto, los subdominios deben tener su propio presupuesto de rastreo si el nombre de host está separado del dominio principal.

¿Cómo puedo identificar las propiedades adecuadas?

Como SEO, tu trabajo es conocer el sitio web mejor que nadie. En la mayoría de los casos, eso no es demasiado difícil porque trabajas con ignorantes digitales. Por lo general, puedes encontrar estos datos en GSC. Pero los sitios más grandes necesitan un poco más de amor.

Rastree su sitio utilizando Screaming Frog, Sitebulb, el artista anteriormente conocido como Deepcrawl, y cree una imagen de la estructura de su sitio si aún no lo sabe. Agregue primero las propiedades más valiosas (primero los ingresos, luego el tráfico) y trabaje desde allí.

Algunas alternativas al GSC

Antes de continuar, sería negligente por mi parte no mencionar algunas excelentes alternativas a GSC. Alternativas que eliminan por completo estas limitaciones para ti.

Pila de SEO

SEO Stack es una herramienta fantástica que elimina todos los límites de consultas y tiene una configuración de estilo MCP incorporada donde realmente puedes hablar con tus datos. Por ejemplo, muéstreme contenido que siempre haya tenido un buen desempeño en septiembre o identifique páginas con un perfil de conteo de consultas de salud.

Daniel ha hablado mucho sobre el recuento de consultas y es una manera fantástica de comprender la dirección que toma su sitio o contenido en la búsqueda. Subir entre las 3 o 10 primeras posiciones es bueno. Bajar hasta allí y subir más abajo es malo.

SEO obtiene

SEO Gets es una alternativa más económica a SEO Stack (que en sí misma no es tan cara). SEO Gets también elimina las limitaciones de filas estándar asociadas con Search Console y hace que el análisis de contenido sea mucho más eficiente.

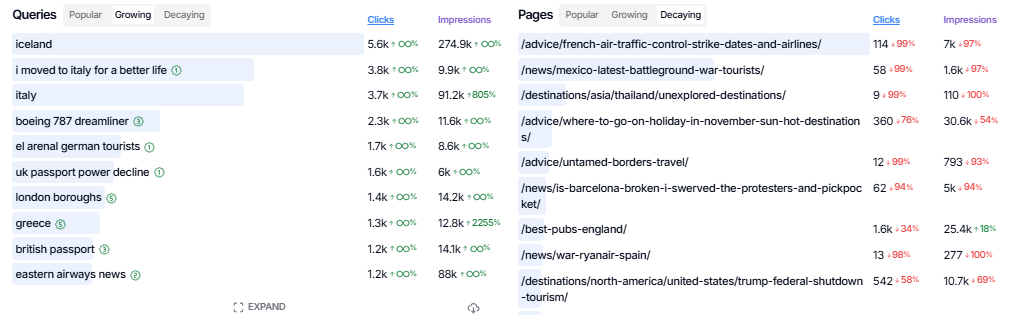

Las páginas y consultas en crecimiento y decadencia en SEO Gets son muy útiles (Crédito de la imagen: Harry Clarkson-Bennett)

Las páginas y consultas en crecimiento y decadencia en SEO Gets son muy útiles (Crédito de la imagen: Harry Clarkson-Bennett)Cree grupos de páginas y palabras clave para el recuento de consultas y el análisis de clics e impresiones a nivel de grupo de contenido. SEO Gets tiene posiblemente la mejor versión gratuita de cualquier herramienta del mercado.

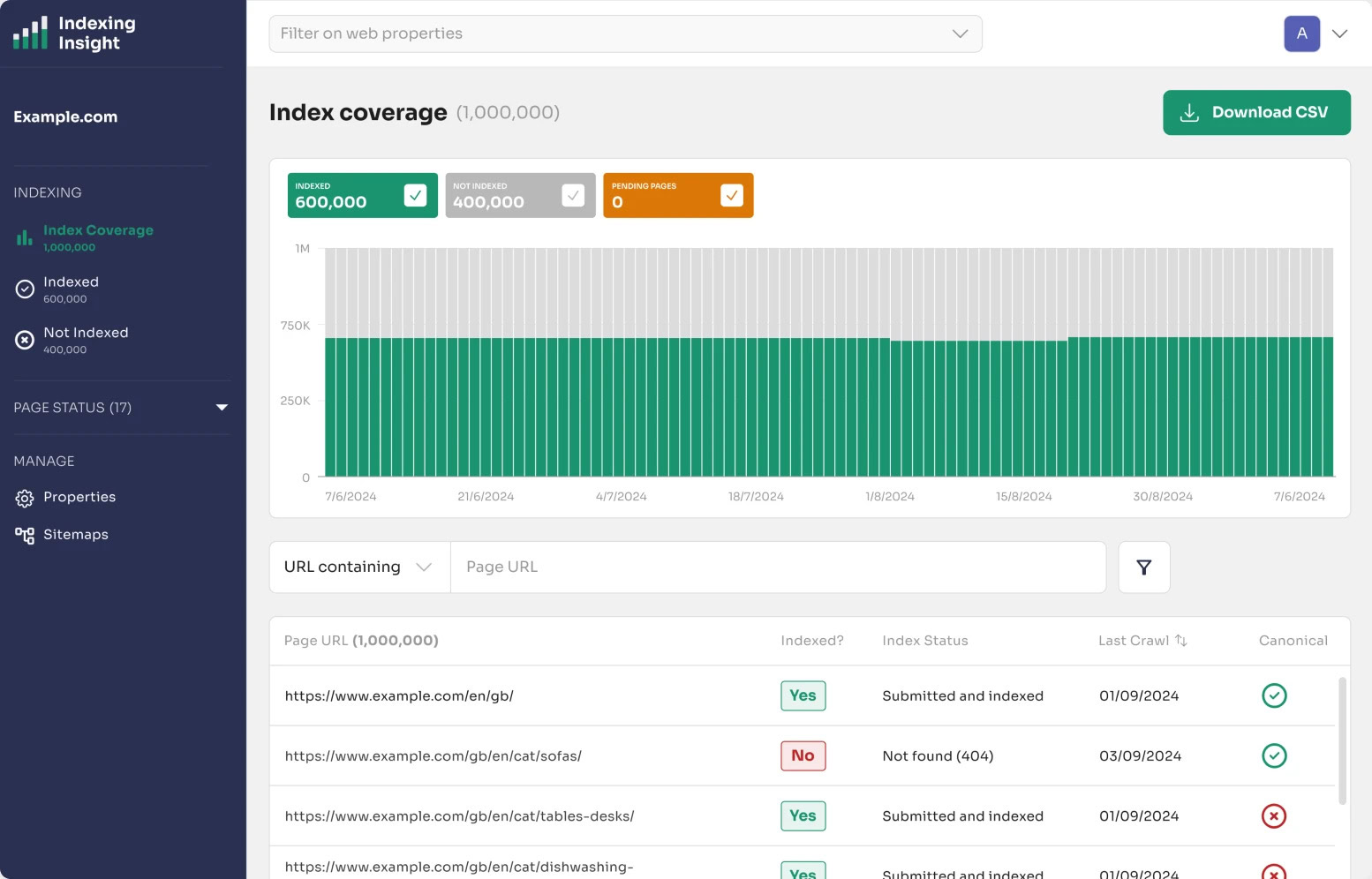

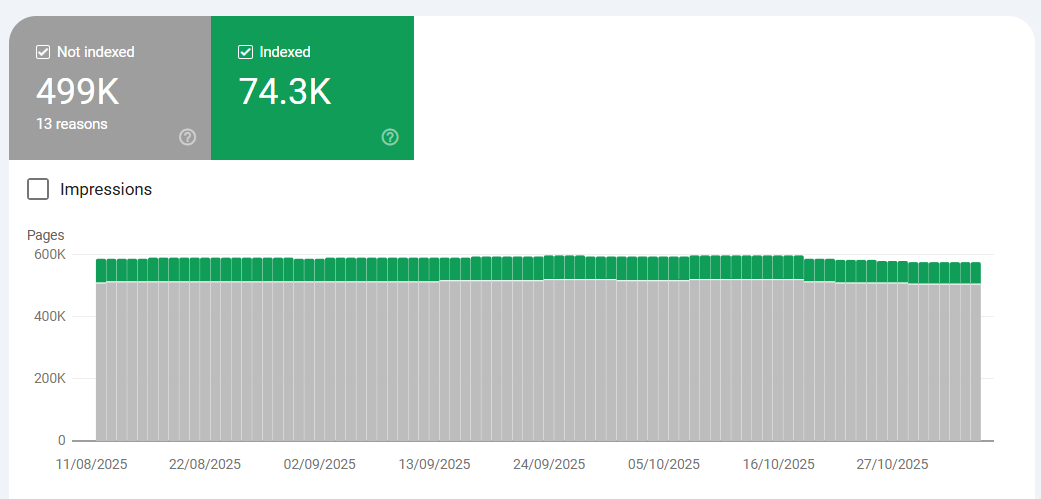

Información sobre indexación

Indexing Insight, la herramienta de análisis de indexación ultradetallada de Adam Gent, es un salvavidas para sitios web grandes y en expansión. 2000 URL por día simplemente no es suficiente para los sitios empresariales. Pero si adoptas inteligentemente el enfoque de propiedades múltiples, puedes aprovechar 2000 URL por propiedad.

Con algunas visualizaciones y puntos de datos excelentes (¿sabías que si una URL no se ha rastreado durante 130 días, desaparece del índice?), necesitas una solución como esta. Particularmente en sitios heredados y empresariales.

Elimine los límites de indexación de 2000 URL por día con la API y el límite de URL de 1000 filas (Crédito de la imagen: Harry Clarkson-Bennett)

Elimine los límites de indexación de 2000 URL por día con la API y el límite de URL de 1000 filas (Crédito de la imagen: Harry Clarkson-Bennett)Todas estas herramientas mejoran instantáneamente su experiencia en Search Console.

Beneficios de un enfoque de propiedades múltiples

Podría decirse que la forma más eficaz de solucionar algunos de los problemas antes mencionados es aumentar el número de propiedades que posee. Por dos razones principales: es gratis y evita las limitaciones principales de la API.

A todo el mundo le gustan las cosas gratis. Una vez pasé por delante de un quiosco que hacía una promoción el día de la inauguración y regalaban latas de tomates picados. Lo cual fue extraño. Lo más extraño fue que había cola. Una cola a la que terminé uniéndome.

Los espaguetis a la boloñesa nunca supieron tan dulces.

Seguimiento de indexación granular

Podría decirse que una de las mejores funciones de Search Console, pero la más limitante, es su análisis de indexación. Comprender las diferencias entre Rastreado – Actualmente no indexado y Descubierto – Actualmente no indexado puede ayudarle a tomar decisiones inteligentes que mejoren la eficiencia de su sitio. Mejorar significativamente su presupuesto de rastreo y estrategias de enlaces internos.

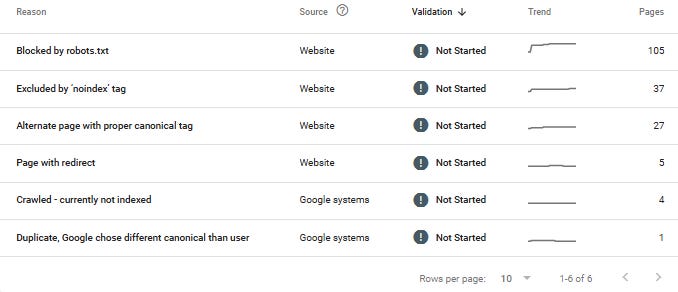

Crédito de la imagen: Harry Clarkson-Bennett

Crédito de la imagen: Harry Clarkson-BennettPáginas que se encuentran en el Rastreado: actualmente no indexado Es posible que el oleoducto no requiera ninguna acción inmediata. La página ha sido rastreada, pero no se considera apta para el índice de Google. Esto podría significar problemas de calidad de la página, por lo que vale la pena asegurarse de que su contenido agregue valor y que sus enlaces internos prioricen las páginas importantes.

Descubierto: actualmente no indexado es ligeramente diferente. Significa que Google encontró la URL, pero aún no la rastreó. Podría ser que la producción de su contenido no esté a la par con el valor percibido por Google de su sitio. O que su estructura de enlaces internos necesita priorizar mejor el contenido importante. O algún tipo de servidor con problema técnico.

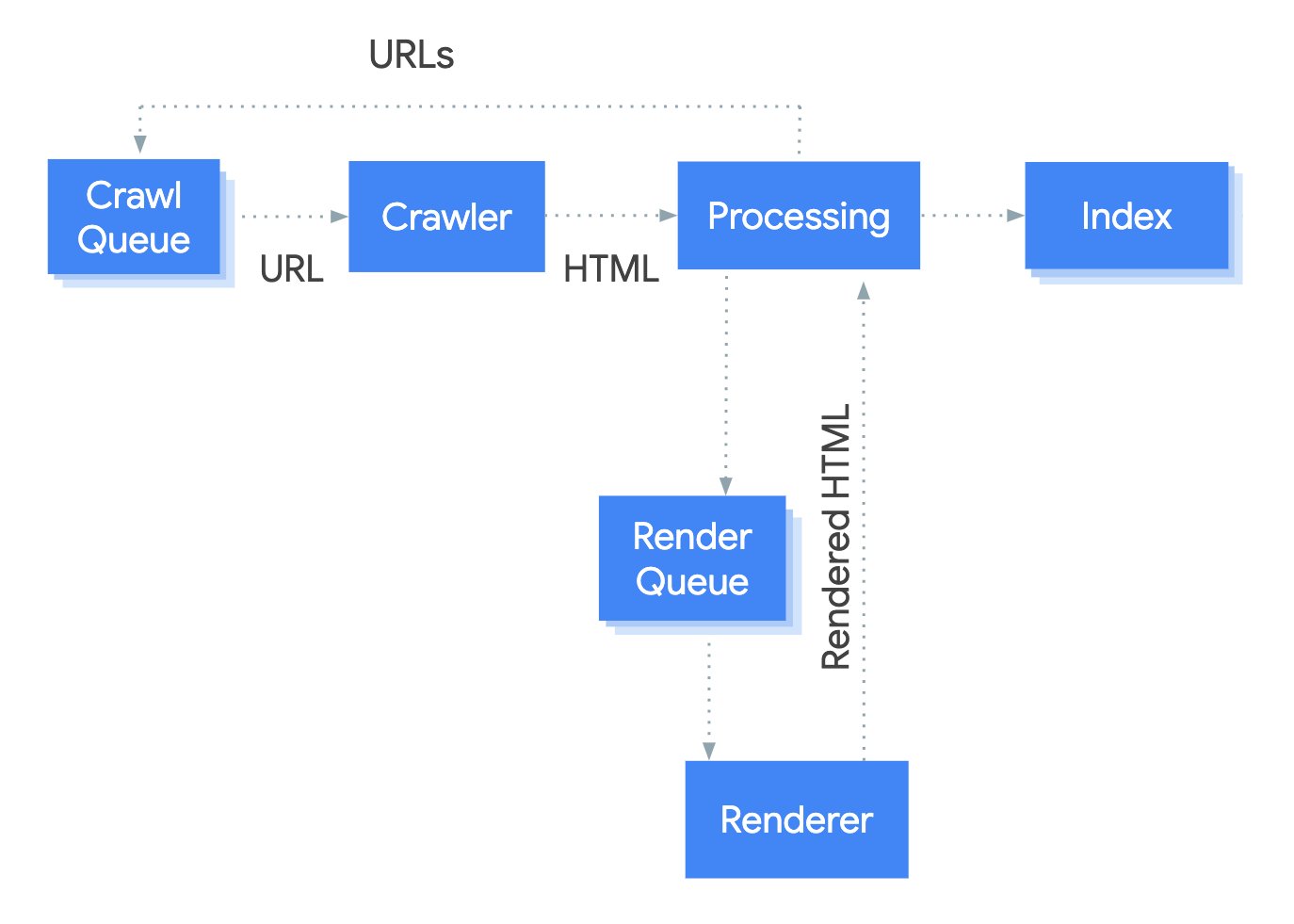

Todo esto requiere al menos una comprensión rudimentaria de cómo funciona el proceso de indexación de Google. No es un enfoque binario. Gary Illyes dijo que Google tiene un sistema de indexación por niveles. El contenido que debe publicarse con más frecuencia se almacena en un sistema más caro y de mejor calidad. El contenido menos valioso se almacena en un sistema menos costoso.

Cómo funciona el sistema de rastreo y renderizado de Google (Crédito de la imagen: Harry Clarkson-Bennett)

Cómo funciona el sistema de rastreo y renderizado de Google (Crédito de la imagen: Harry Clarkson-Bennett)Menos mono ve, mono hace; Más mono ve, mono toma decisiones según el valor del sitio, el presupuesto de rastreo, la eficiencia, la carga del servidor y el uso de JavaScript.

El enfoque escalonado de la indexación prioriza el valor percibido y el HTML sin procesar de una página. JavaScript está en cola porque requiere muchos más recursos. De ahí que los SEO insistan en que su contenido se represente en el lado del servidor.

Adam tiene una muy buena guía sobre los tipos de páginas no indexadas en GSC y lo que significan aquí.

Vale la pena señalar que la herramienta de indexación de páginas no está completamente actualizada. Creo que se actualiza un par de veces por semana. Pero no recuerdo de dónde saqué esa información, así que no me obligues a decir eso…

Si es un gran editor de noticias, verá gran parte de su contenido más nuevo en la categoría Rastreado: actualmente no indexado. Pero cuando inspeccionas la URL (lo cual es absolutamente necesario hacer), es posible que esté indexada. Hay un retraso.

Escalabilidad de API de indexación

Cuando empiezas a trabajar en sitios web más grandes (y me refiero a sitios web donde las subcarpetas tienen más de 500.000 páginas), la limitación de 2.000 URL de la API se vuelve evidente. Simplemente no se pueden identificar eficazmente las páginas que entran y salen de la sección “¿Por qué las páginas no están indexadas?” sección.

No es genial, he visto cosas peores (Crédito de la imagen: Harry Clarkson-Bennett)

No es genial, he visto cosas peores (Crédito de la imagen: Harry Clarkson-Bennett)Pero cuando configuras varias propiedades, puedes escalar de manera efectiva.

El límite de 2000 solo se aplica a nivel de propiedad. Entonces, si configura una propiedad a nivel de dominio junto con otras 20 propiedades (a nivel de subcarpeta), puede aprovechar hasta 42 000 URL por día. Cuanto más hagas, mejor.

Y la API tiene otros beneficios:

Pero no garantiza la indexación. Es una petición, no una orden.

Para configurarlo, debe habilitar la API en Google Cloud Console. Puede seguir esta guía de inicio rápido semiútil. No es divertido. Es un dolor de cabeza. Pero vale la pena. Luego necesitará una secuencia de comandos de Python para enviar solicitudes de API y monitorear las cuotas y respuestas de API (2xx, 3xx, 4xx, etc.).

Si desea ser más sofisticado, puede combinarlo con sus datos de publicación para calcular exactamente cuánto tiempo tardan en indexarse las páginas de secciones específicas. Y siempre debes querer ser elegante.

Esta también es una muy buena señal sobre cuáles son sus subcarpetas más importantes a los ojos de Google. Categorías de desempeño versus categorías de bajo desempeño.

Datos granulares de clics e impresiones

Un imprescindible para sitios grandes. La Search Console predeterminada no solo almacena 1000 filas o datos de consultas y URL, sino que solo los almacena durante 16 meses. Si bien parece mucho tiempo, avance uno o dos años y deseará haber comenzado a almacenar los datos en BigQuery.

Especialmente cuando se trata de observar el comportamiento interanual de clics y la planificación de eventos. El rechinar de dientes por sí solo pagará el viaje anual de su dentista a Aruba.

Pero, con diferencia, la forma más sencilla de ver los datos de búsqueda a un nivel más granular es crear más propiedades GSC. Si bien todavía tiene los mismos límites de consultas y URL, debido a que tiene varias propiedades en lugar de una, los límites de datos se vuelven mucho menos limitantes.

¿Qué pasa con los mapas de sitio?

No está directamente relacionado con la indexación de GSC, pero es un punto a tener en cuenta. Los mapas de sitio no son una herramienta particularmente poderosa en su arsenal cuando se trata de fomentar la indexación de contenido. La indexación de contenido depende de lo “útil” que sea para los usuarios.

Ahora bien, sería negligente por mi parte no resaltar que los mapas de sitios de noticias son ligeramente diferentes. Cuando la velocidad de publicación y la indexación son tan importantes, querrás resaltar tus artículos más recientes en un lugar ratificado.

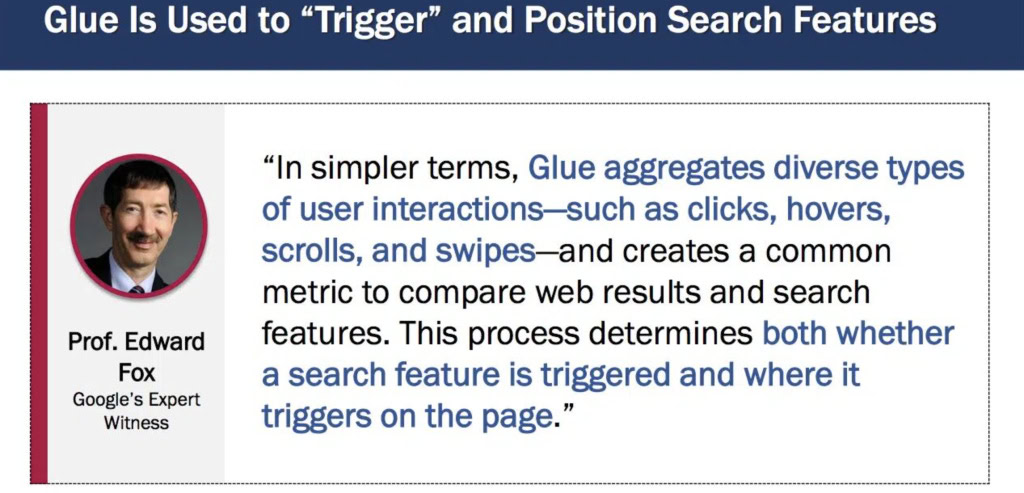

En última instancia, todo se reduce a Navboost. Clics buenos versus malos y el último clic más largo. O en un sentido más informativo, Pegamento – una enorme tabla de interacciones de usuarios, diseñada para clasificar contenido nuevo en tiempo real y mantener el índice dinámica. La indexación se debe a que su contenido es lo suficientemente valioso para los usuarios como para que Google continúe almacenándolo en su índice.

Glue enfatiza las señales de interacción inmediata, como pasar el cursor y deslizar el dedo para obtener comentarios más instantáneos (Crédito de la imagen: Harry Clarkson-Bennett)

Glue enfatiza las señales de interacción inmediata, como pasar el cursor y deslizar el dedo para obtener comentarios más instantáneos (Crédito de la imagen: Harry Clarkson-Bennett)Gracias a décadas de experiencia (y la confirmación a través de la prueba del DoJ y la filtración de Google), sabemos que la autoridad de su sitio (Q*), el impacto en el tiempo y la estructura de enlaces internos juegan un papel clave. Pero una vez indexado, todo es cuestión de participación del usuario. Con mapa del sitio o sin él, no puedes obligar a las personas a amar tu contenido beige y miserable.

¿Y los índices de mapas de sitios?

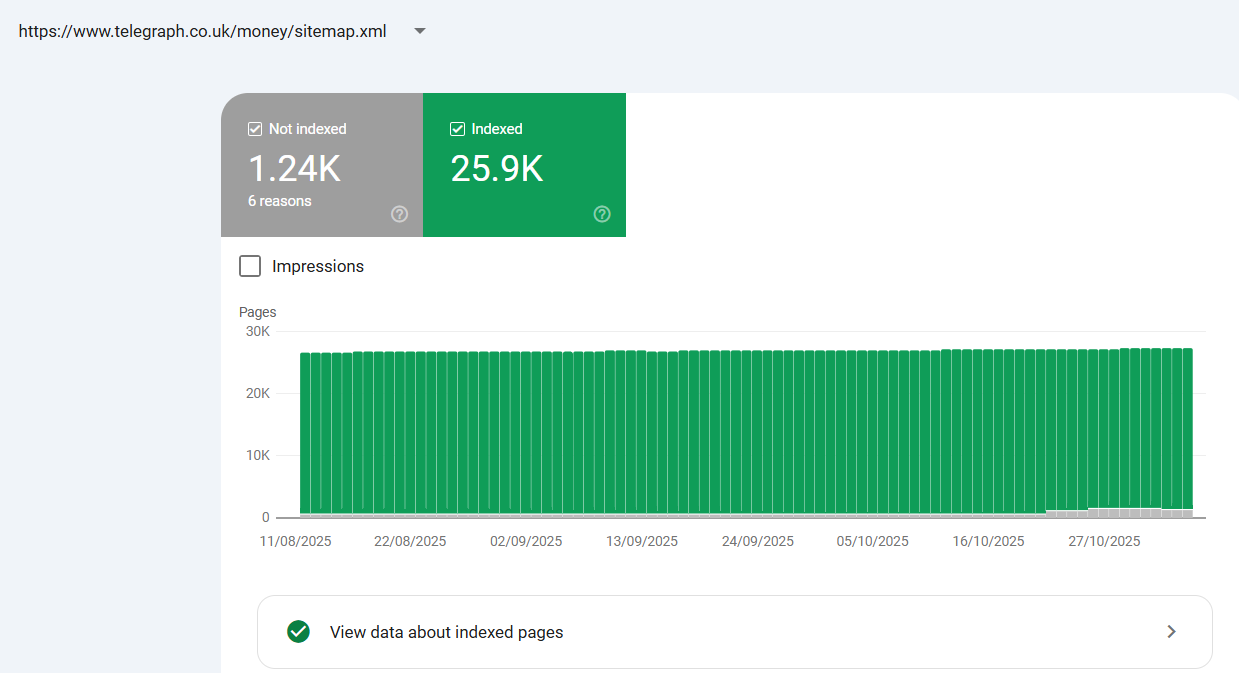

La mayoría de los sitios más grandes utilizan índices de mapas de sitios. Básicamente, un mapa de sitio de mapas de sitio para administrar sitios web más grandes que superan el límite de 50.000 filas. Cuando cargue el índice del mapa del sitio en Search Console, no se detenga allí. Cargue cada mapa de sitio individual en su índice de mapas de sitio.

Esto le brinda acceso a la indexación a nivel de mapa del sitio en el informe de indexación de páginas o mapas del sitio. Algo que es mucho más difícil de gestionar cuando tienes millones de páginas en un índice de mapa de sitio.

Ver datos a nivel de mapa del sitio proporciona datos de indexación más granulares en GSC (Crédito de la imagen: Harry Clarkson-Bennett)

Ver datos a nivel de mapa del sitio proporciona datos de indexación más granulares en GSC (Crédito de la imagen: Harry Clarkson-Bennett)Adopte el mismo enfoque con los mapas de sitio que hemos analizado con las propiedades. En general, más es mejor.

Vale la pena saber que cada documento también se entrega un ID de documento. El DocID almacena señales para calificar la popularidad de la página: clics de los usuarios, su calidad y autoridad, datos de rastreo y una puntuación de spam, entre otros.

Todo lo clasificado como crucial para clasificar una página se almacena y utiliza con fines de indexación y clasificación.

¿Qué debo hacer a continuación?

- Evalúe su configuración actual de GSC: ¿está funcionando lo suficiente para usted?

- ¿Tiene acceso a una propiedad a nivel de dominio y a un informe de estadísticas de rastreo?

- ¿Ya ha dividido su sitio en “propiedades” en GSC?

- De lo contrario, rastree su sitio y establezca las subcarpetas que desea agregar.

- Revise la configuración de su mapa del sitio. ¿Tiene simplemente un índice de mapa del sitio? ¿También has agregado los mapas de sitio individuales a GSC?

- Considere conectar sus datos a BigQuery y almacenarlos durante más de 16 meses.

- Considere conectarse a la API a través de Google Cloud Console.

- Revise las herramientas anteriores y vea si agregarían valor.

En definitiva, Search Console es muy útil. Pero tiene importantes limitaciones y, para ser justos, es gratis. Otras herramientas lo han superado en muchos sentidos. Pero al menos debes hacer que funcione lo más duro posible.

Más recursos:

Esta publicación se publicó originalmente en Liderazgo en SEO.

Imagen de portada: N Universe/Shutterstock

(etiquetasToTranslate)SEO